封面新闻记者 边雪

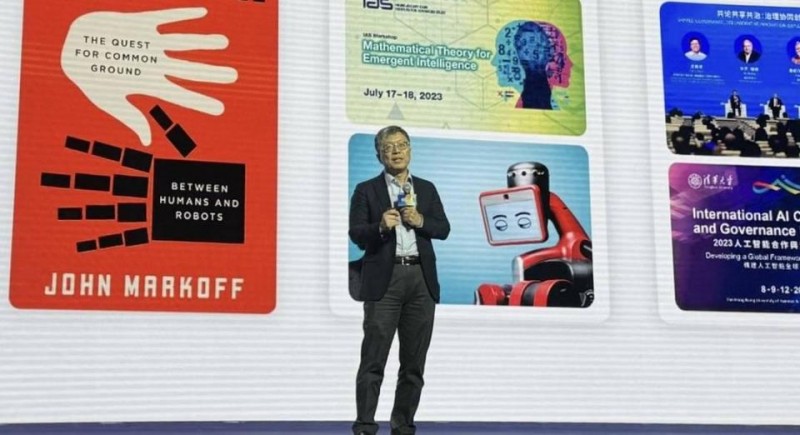

在2025全球开发者先锋大会的主论坛上,香港科技大学校董会主席、美国国家工程院外籍院士沈向洋以《大模型时代的创新与思考》为题,勾勒出一幅人工智能未来发展的全景图。从开源生态的崛起、大模型技术范式的革新,到人机交互的终极命题,这位深耕AI领域三十余年的科学家,以冷静的洞察为行业指明方向。

从技术进步的角度看开源,开源并非新事物,但其蓬勃发展始于互联网的出现后。互联网极大增强了全球合作开源的能力。谈及开年爆火的,沈向洋告诉封面新闻记者,“DeepSeek让大家看到开源社区的胜利。把了不起的模型开源后,让更多人得到机会,在这个模型上做更多了不起的事情”。

开源:

从“技术共享”到“全球协作”的进化论

当被问及“DeepSeek等中国开源模型为何能引发全球关注”时,沈向洋直言:“开源社区的胜利,本质上是人类协作智慧的胜利。”他以Linux和Apache的早期发展为例,指出互联网时代的技术革命始终与开源精神相伴相生,“但今天的大模型开源,已不仅是代码的开放,更是数据、算力、人才甚至价值观的全球协作。”

这一观点在当下AI行业格局中得到印证。尽管OpenAI、谷歌等巨头凭借闭源模型占据先发优势,但meta开源的Llama系列、DeepSeek的MoE架构模型,正通过开源策略构建生态护城河。沈向洋特别提到,2024年GitHub的统计显示,来自中国的开发者对全球AI开源项目的贡献率已超过30%,“这不仅是技术的流动,更是创新范式的重构。”

对于“开源与闭源是否对立”,沈向洋也用商业选择的角度进行阐释。纵观2023到2024年,不同公司开发的模型在企业实际使用中的比例,市场份额从高到低的大模型,开、闭源策略各不相同,与其市场份额没有明显关联。2024年全球企业采用的大模型中,开源与闭源占比接近5:5,但采用开源模型的企业二次开发率高达78%,远超闭源的12%。或许在未来,赢家可采用“混合模式”——用闭源确保核心优势,用开源扩大生态影响力。

技术范式革命:

从“快思考”到“慢思考”的跃迁

诺贝尔经济学奖得主,丹尼尔·卡尼曼在他的著作《思考快与慢》中提出,人类的认知系统分成两部分:“快思考”是本能的、直觉的反应;“慢思考”是理性的、逻辑推理,是真正意义上的思考。现阶段的大模型虽然已经取得了巨大的突破,但更像是人类大脑的“快思考”,业界普遍认为,能否演进出“慢思考”的能力,是大模型发展历程上关键的一步。

“如果说GPT是‘快思考’,那么Reasoner则更注重‘任务是否完成’。”沈向洋解释,GPT模式依赖海量数据的概率拟合,通过“下一个token预测”实现快速响应;而Reasoner模式则引入递归推理机制,允许模型像人类一样拆解复杂问题、试错修正。

这一转变正引发行业技术路线的分化。记者注意到,2024年以来,谷歌的Gemini Pro已尝试在数学证明任务中嵌入符号推理模块,而清华大学的CogAgent则在视觉-语言推理任务中实现了85.3%的准确率突破。沈向洋认为,Reasoner模式的价值在于“可解释性”和“可靠性”的提升,“当AI需要处理医疗诊断或法律合规模块时,单纯的统计学关联远远不够。”

但挑战也随之而来。

最大的瓶颈是开源数据,“我希望开源社区能贡献更多数据,在新的范式里,大家一起有更大的进步”。沈向洋指出,当前高质量推理数据集(如学术论文推导链、工程师调试日志)的开放比例不足15%,远低于通用文本数据。“这需要建立新的数据共享机制——或许可以通过区块链技术实现贡献激励,让数据开源进入2.0时代。”

人机交互:

争夺“下一代入口”的终极战场

“回顾个人电脑、智能手机的崛起史,每一次人机交互方式的革命都会催生万亿市值的巨头。”沈向洋将话题转向更具哲学意味的领域,“现在我们正站在自然交互的临界点。”

以Agent(智能体)为核心的交互体系将重塑所有行业吗?封面新闻记者观察到,这一趋势已初现端倪:微软将Copilot深度植入Windows 12操作系统,苹果的AI Agent能通过Siri协调智能家居与日程管理,而中国的科技公司则在政务、金融领域推广“数字员工”。沈向洋特别强调多模态交互的颠覆性:“当AI能通过一个眼神、手势甚至脑电波理解意图时,交互效率的提升将是指数级的。”

但对于“AI取代人类”的担忧,沈向洋更倾向“智能增强”(IA)的路径。智能增强(IA)是指通过技术扩展人类的能力,帮助人们更高效地完成任务,而不是取代人类。沈向洋指出了一个角度,“是以人为本的人工智能”,呼吁关注人工智能的伦理问题,“与各位开发者一起共鸣”

在“重构”与“延续”的历史问题之间,真正伟大的技术从不是颠覆,而是让人更成为人。

欧盟2024年通过的《人工智能责任法案》,其中要求核心领域AI系统必须提供“决策溯源路径”,这正是Reasoner模式的技术优势。谈及AI伦理的提问,沈向洋表示:“当我们讨论对齐(Alignment)问题时,不能仅停留在‘不让AI说错话’的层面。”